みなさん、こんにちは

本日投稿の内容について、以前別サイトで私が投稿したブログの内容です。

サイトの閉鎖に伴い、こちらで再度掲載いたします。

今回はNutanixのデータ保護に関してご紹介します。

内容は若干長いため、2回に分けてご紹介します。

(画像の⼀部はNutanix様の資料から拝借させて頂いております)

1.Site Failover Operations

サイトがフェイルオーバーした時のオペレーションのことを考えてみましょう。

まず、スナップショットとレプリケーションのスケジュールを設定した後で、あるサイトから別のサイトにフェイルオーバーする必要があるかもしれません。 3つのフェイルオーバーシナリオが可能です。

計画的フェイルオーバー︓

両⽅のサイトが稼働していて、その構成が正しく機能することをテストしたい場合、または1次サイトの計画的保守またはサイト拡張の前にフェイルオーバーします

災害時フェイルオーバー︓

プライマリサイトが停⽌したときのフェイルオーバー

フェイルバック︓

システム停⽌を解決してプライマリサイトに戻したい場合に、復旧サイトから計画的フェイルオーバーを開始します

2.計画的なフェイルオーバーもしくはフェイルバック

この操作は以下のことを行います。

- 保護ドメインのスナップショットを作成して複製します。

- ローカルサイトのVMをシャットダウンします。

- 保護ドメインの別のスナップショットを作成して複製します。

- すべてのVMの登録を解除し、それらに関連付けられているファイルを削除します。

- ローカルサイト保護ドメインを非アクティブとしてマークします。

- 最後のスナップショットからすべてのVMファイルを復元し、 それらをリモートサイトに登録します。

- リモートサイト保護ドメインをアクティブとしてマークします。

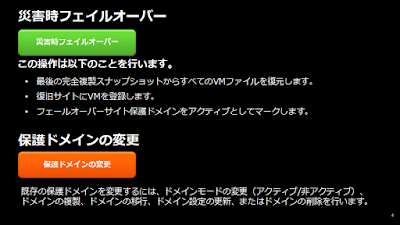

3.災害時フェイルオーバー/保護ドメイン

- 最後の完全複製スナップショットからすべてのVMファイルを復元します。

- 復旧サイトにVMを登録します。

- フェールオーバーサイト保護ドメインをアクティブとしてマークします。

保護ドメイン変更操作は以下のことを行います。

既存の保護ドメインを変更するには、ドメインモードの変更(アクティブ/非アクティブ)、ドメインの複製、ドメインの移行、ドメイン設定の更新、またはドメインの削除を行います。

4.保護ドメインのガイドライン

メトロアベイラビリティポリシーを適用するための一般的なガイドライン

保護ドメインは、ローカルクラスタ上のプライマリストレージコンテナと、リモートクラスタ上の同じ名前のスタンバイストレージコンテナを指定することによって作成されます。以下は、メトロアベイラビリティを適用するための設定とガイドラインです。

- ストレージコンテナをメトロアベイラビリティで使用する場合、データストア名はストレージコンテナ名と同じである必要があります。

- 2つのサイトにわたるデータストアの可用性を確保するには、両方のサイトにリアルタイムでデータが存在する必要があります。したがって、クラスタ間のラウンドトリップレイテンシは5ms未満である必要があります。

- ピーク書き込みに対応するために十分な帯域幅を維持します。サイト間に冗長な物理ネットワークを用意することをお勧めします。

- 特定のVMに関連付けられているすべての仮想ディスクが、メトロアベイラビリティが有効になっているコンテナに存在することを確認します。

- 保護されたVMは、アクティブストレージコンテナに関連付けられているNutanixクラスタまたはスタンバイストレージコンテナに関連付けられているクラスタのどちらでも実行できます。ただし、スタンバイストレージコンテナに関連付けられているクラスタ上でVMが実行されていると、アクティブストレージコンテナへのネットワークを介して読み取りと書き込みが行われます。したがって、ネットワークトラフィックとそれに関連するネットワークの待ち時間を減らすために、VMのデータが存在するアクティブコンテナに対してVMのデータがローカルに実行されるアクティブコンテナに対してVMをローカルに実行することをお勧めします。

- メトロアベイラビリティポリシーはストレージコンテナ(クラスタではなく)ごとに適用されるため、クラスタはあるデータストアに対してアクティブで、別のデータストアに対してスタンバイになることができます。たとえば、ストレージコンテナ1にOracleデータストア(データストアA)、ストレージコンテナ2にExchangeデータストア(データストアB)を持つクラスタ構成を考えます。クラスタAはデータストアAに対してアクティブで、クラスタBはスタンバイです。データストアBに対してアクティブで、クラスタAをスタンバイにします。さらに、メトロアベイラビリティのストレージコンテナは、同じクラスタ内の通常のストレージコンテナと共存できます。

5.VMセントリックのデータ保護

AOSは、ネイティブのオンサイトバックアップと、オフサイトバックアップおよびディザスタリカバリ用のリモートレプリケーションの両方に統合データ保護ソリューションを提供します。

これらの機能は、スナップショットがソースVMと同じクラスターに格納されるタイムストリームと、スナップショットがクラスター間で非同期に複製されるサイト間レプリケーションの2つのユースケースで使用できます。

VMのスナップショットはクラッシュコンシステントです。つまり、VMDKのオンディスクイメージは一時点で一貫性を保っています。つまり、スナップショットはVMがクラッシュしたかのようにディスク上のデータを表します。状況によっては、スナップショットもアプリケーションと整合性があります。

つまり、スナップショットの時点でアプリケーションデータが静止します。アプリケーション整合性のあるスナップショットは、ESXiハイパーバイザーによってホストされているVMにインストールできる一連のユーティリティであるVMware Toolsを介して適用されます。この機能はVSSを起動してVM用のアプリケーション整合性のあるスナップショットを作成します。これは単一のVMを持つ整合性グループに限定されます。

スナップショットは、定義されたスケジュールまたは必要に応じて作成できます。作成されたすべてのスナップショットは有効期限に関連付けられており、有効期限が過ぎるとNutanixクラスタは自動的にスナップショットを削除します。重要ではないVMファイル(スワップファイルやログファイルなど)はスナップショットに含まれません。

6.データ保護の概念

- 保護ドメイン

保護ドメイン(非同期DR):標準保護ドメインは、クラスター上でローカルにバックアップされ、オプションで1つ以上のリモートサイトに複製された定義済みのVMのグループです。このタイプの保護ドメインは、スナップショットを作成するために非同期データ複製Async D)を使用します。

保護ドメイン名はサイト間で一意である必要があります。 VMは最大1つの保護ドメインに属することができます。クラスタ上の保護ドメインは、次の2つのモードのいずれかにあります。

アクティブ:稼働中のVMを管理します。スナップショットを作成、複製、およびExpireします。

非アクティブ:リモートクラスタからスナップショットを受け取ります。

保護ドメイン(メトロ可用性):メトロ可用性保護ドメインは、メトロ可用性が有効になっているときに同期データ複製が行われるリモートサイトの同じ名前の(スタンバイ)コンテナにリンクされたローカルクラスタの指定(アクティブ)コンテナで構成されます。

- 整合性グループ

整合性グループは、保護ドメイン内のVMのサブセットです。 (保護ドメインを作成するときに整合性グループが構成されます)。その保護ドメインのコンシステンシグループ内のすべてのVMは、クラッシュコンシステントな方法でスナップショットを取られます。コンシステンシグループ内のすべてのVMに対して、スナップショットはグループ内のすべてのVMに対して1つのスナップショットを作成します。

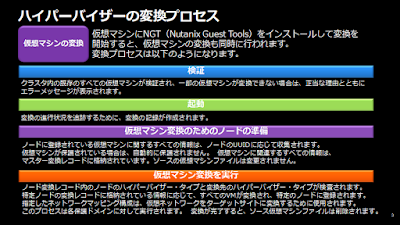

データ保護を⾏う上で重要なのは、スナップショットを取ったデータが整合性を保っていることが重要です。リストア後に整合性が保った状態に戻すのはアプリケーション次第ではあるが、クラッシュコンシステントのバックアップで停電後でも仮想マシンの電源⼊れている状態に戻せるようにしておきましょう。仮想マシンには必ずNGT(Nutanix Guest Tools)を⼊れておきましょう。

- スナップショット

- タイムストリーム

リモートサイトは、バックアップデータを複製するためのターゲットの場所として使用される独立したクラスタです。リモートサイトは、別の物理クラスタまたはパブリッククラウドにあるクラスタのどちらでもかまいません。 1つのクラスタに1つ以上のリモートサイトを設定できます。

- レプリケーション

レプリケーションとは、スナップショットを1つのクラスタから1つ以上のリモートサイトに非同期的にコピーするプロセスです。いくつかのレプリケーションシナリオがサポート

レプリケーションについては、1つもしくは複数サイトにレプリカを作成することができます。注意事項としては、マルチサイトで複製取る場合には、ライセンスのエディションにご注意下さい。(UltimateもしくはPro Edition選択時はオプションのライセンスが必要になります)

- スケジュール

スケジュールは、スナップショットをとる間隔とスナップショットを保持する期間を指定する保護ドメインの特性です。 (保護ドメインを設定するときにスケジュールが設定されます)。スケジュールは、どのリモートサイトに複製するかをオプションで指定します。

スケジューリングについては、⾮同期DRについては間隔が短い場合はNear Syncになりますので、その場合は仕様も含めて確認してから設定してください。

本⽇のデータ保護の説明は以上とさせて頂きます。

次回は、複製の⽅式についてご説明したいと思います。

よろしくお願い致します。